Instalando o PySpark em um ambiente virtual Python

publicado em 04/jan/2024

Neste mini-tutorial estou utilizando o Ubuntu na versão 23.10, e o Python na versão 3.11, porém acredito que este procedimento funcione com o python3.7 em diante, e em outras distribuições do Ubuntu.

Também já tenho o Java instalado em meu pc, certifique-se que os comandos seja reconhecido em seu terminal.

java --version

javac --versionO primeiro passo é criar um ambiente Virtual

python -m venv venv-bigdataAgora ativaremos o ambiente virtual recém criado

source venv-bigdata/bin/activate

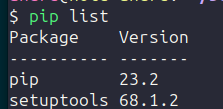

No momento não há nada instalado em nosso ambiente

pip list

Instalando o pyspark

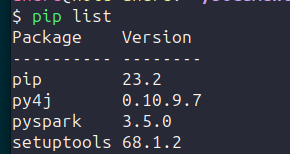

pip install pysparkExecutando o comando ‘pip list’ novamente para vermos o que foi instalado, teremos como output o seguinte resultado:

O PySpark e sua dependência py4j foram instalados com sucesso

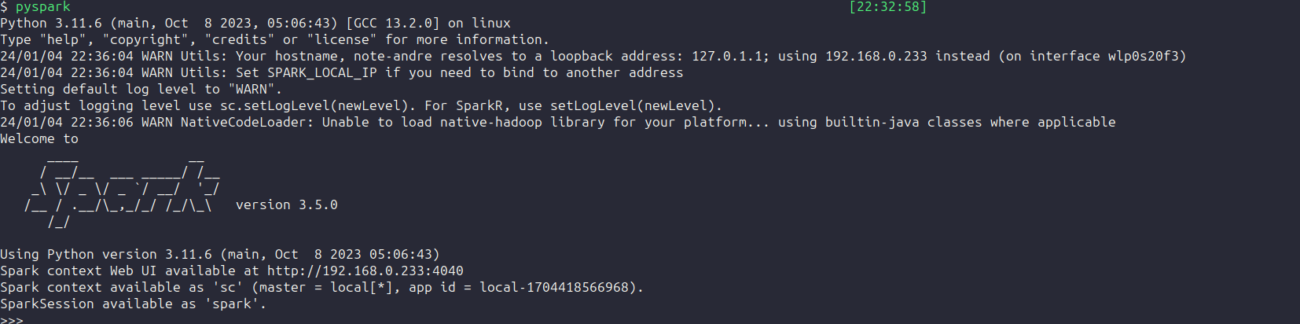

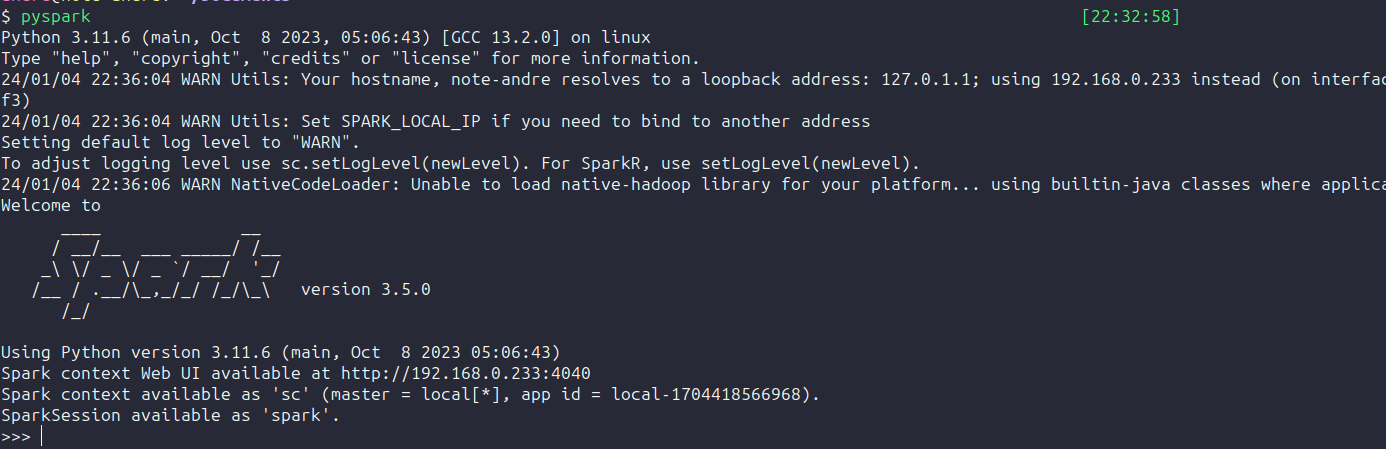

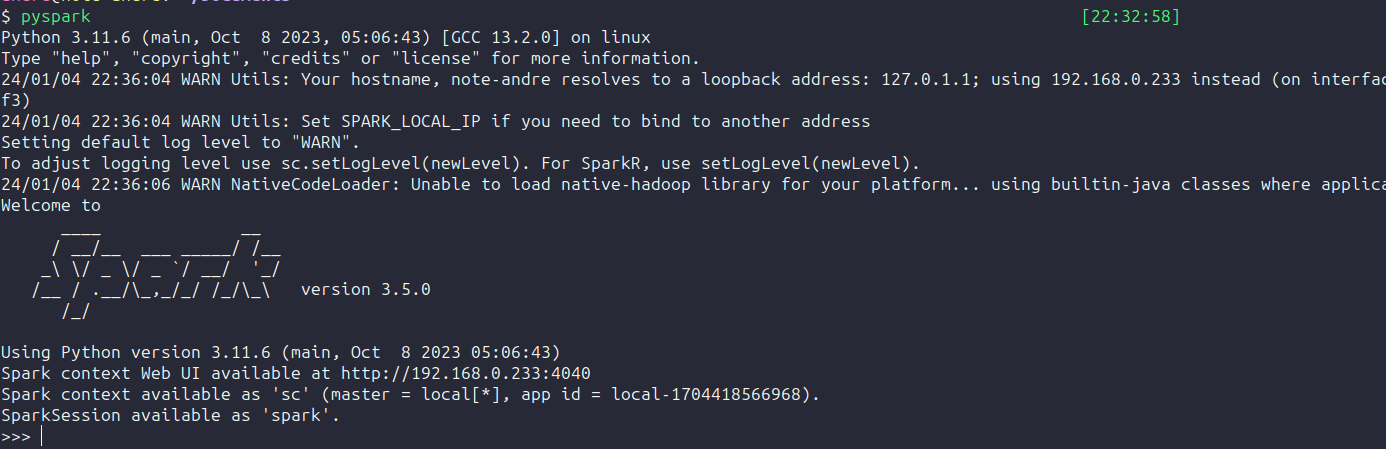

pyspark